使用UpHub AI在纯CPU上运行Gemma3 12B(4B)大模型进行对话

安装好UpHub AI,是不是想马上在自己的电脑上运行一个大模型试试呢?

好吧,我们现在以在普通CPU上,在没有GPU的情况下如何运行Gemma3 12B版本。

通常运行大模型的步骤:(1)准备硬件环境;(2)安装推理方案的程序(比如:UpHub AI);(3) 下载大模型权重文件(比如从:modelscope、Huggingface等仓库中下载);(4) 运行大模型;(5) 输入问题,即可。

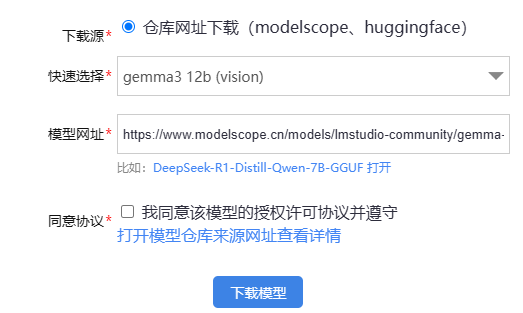

现在我们来到了下载大模型的步骤,在UpHub AI中下载大模型,可以有两种方式,一种是在模型网站上手动下载投放到models目录中即可,另一种是能通过辅助下载程序,输入网址系统自动下载,下载完成后,即可运行大模型。

UpHub AI个人版支持gguf量化格式的大模型。

比如:gemma-3-12b-it-GGUF,可以通过以下网址进行下载:

gemma-3-12b-it-GGUF版(至少64GB内存,M2固态硬盘):

https://www.modelscope.cn/models/lmstudio-community/gemma-3-12b-it-GGUF

gemma-3-4b-it-GGUF版 (配置低的可选择4B版本):

https://www.modelscope.cn/models/lmstudio-community/gemma-3-4b-it-GGUF

在UpHub AI中,只要输入上述网址,点击下载即可。

等待下载完成,这要看您的网速,这个文件有好几GB。

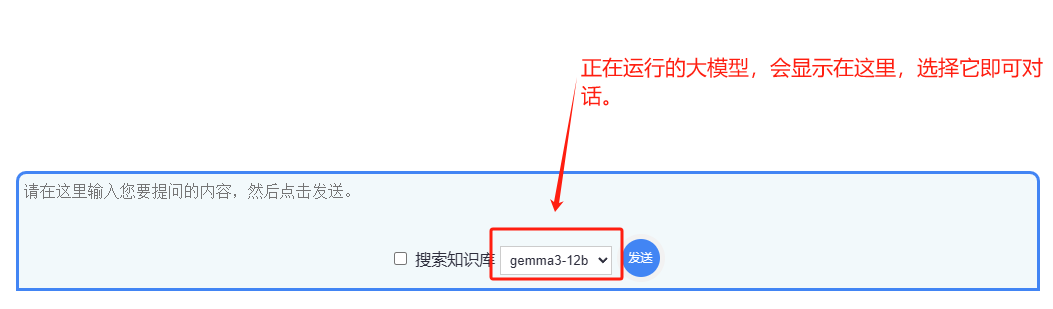

下载好后,在M管理中(模型管理),选择它,点击运行即可。

大模型一旦启动,在对话框的模型列表中就可以选择它,然后向它提问了。

选择模型

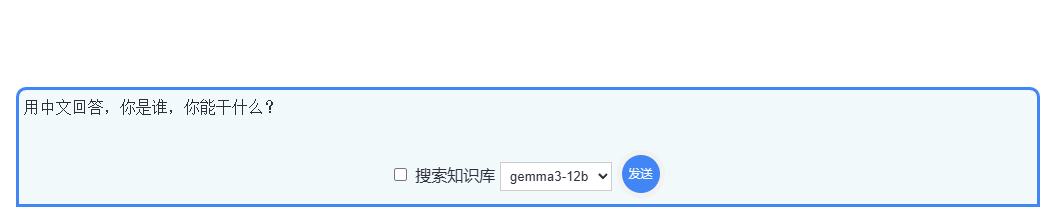

和AI对话

本例和Gemma3 12B对话 3.6 tokens/s