实施AI大模型本地化部署和推理需要准备什么硬件和资源?需要什么条件?

实施AI大模型本地化部署和推理条件是一个涉及多个方面并且复杂问题,本文将从以下几个关键点进行阐述:

下载本地大模型部署推理软件UpHub AI,请点击这里。

1. 硬件基础设施

- 强大的计算能力: 大模型推理需要大量的计算资源,尤其是GPU。

- GPU选择: 选择合适的GPU至关重要。NVIDIA的A100、H100系列GPU是目前主流的选择,但根据模型大小和推理速度要求,也可以考虑消费级显卡(比如:RTX3090, 4090,5090等)或其他厂商的GPU,例如AMD的MI系列。如果需要运行多模态大模型(比如图片描述等视频Vision处理,则必须要具有GPU,才能提高速度)

- GPU数量: 模型越大,需要的GPU数量越多。可以采用模型并行、流水线并行等技术来提高GPU利用率。

- CPU: 虽然GPU是核心,但CPU仍然需要足够的性能来处理数据预处理、模型加载等任务。一些中小模型还可以通过量化方式直接在CPU上运行,不需要GPU(比如:Deepseek-R1 1.5B、7B、8B、14B、32B、70B等),Q4量化版可以在CPU上直接运行。

- 充足的内存 (RAM): 大模型需要大量的内存来加载模型参数和进行推理计算。

- RAM容量: RAM容量需要根据模型大小和批处理大小来确定。一般来说,模型越大,需要的RAM也越多。一般最小的模型也建议在32GB高速内存(DDR5+)以上。

- 高速存储: 快速的存储可以加快模型加载速度和数据传输速度。

- NVMe SSD: NVMe SSD是目前最常用的存储设备,可以提供极高的读写速度,NVMe SSD是运行大模型的必要前提,因为大模型第一步就是从磁盘上加载到内存,如果磁盘读取很慢,则加载时间可能需要几十分钟甚至更长,如果用NVMe SSD则大部分中小规模的模型加载只需要几秒。

- 网络带宽: 如果模型需要在多台机器之间进行推理,需要高速的网络带宽来保证数据传输效率。

2. 软件环境

- 操作系统: Linux是AI开发和部署的首选操作系统,因为它具有良好的性能、稳定性和丰富的工具支持(当然一般的个人部署和推理,使用windows 10、windows 11也可以,而且部署更简单)。

- 深度学习框架: 选择合适的深度学习框架,例如PyTorch、TensorFlow、JAX等。

- CUDA和cuDNN: 如果使用NVIDIA GPU,需要安装CUDA和cuDNN,它们是NVIDIA提供的用于GPU计算的工具包。

- 模型优化工具: 使用模型优化工具来减小模型大小、提高推理速度。

- 模型量化: 将模型参数从浮点数转换为整数,可以减小模型大小并提高推理速度,中小团队或个人,建议使用量化版部署,硬件成本将大幅降低,可以选择UpHub AI进行实施部署,无需一条命令、不需一行代码、像安装部署软件一样就可以在Winwos 10、Windows 11等Windows 64倍系统上部署AI大模型。

- 模型剪枝: 删除模型中不重要的连接,可以减小模型大小并提高推理速度。

- 模型蒸馏: 将大模型的知识迁移到小模型,可以减小模型大小并提高推理速度,比如:Deepseek-R1 7B,8B,14B等均为迁移模型。

- 推理服务器: 选择合适的推理服务器来部署和运行模型。

- NVIDIA Triton Inference Server: 一个高性能的推理服务器,可以支持多种深度学习框架和模型格式。

- TensorFlow Serving: 一个用于部署TensorFlow模型的推理服务器。

- TorchServe: 一个用于部署PyTorch模型的推理服务器。

3. 模型本身

- 模型选择: 选择适合本地部署的模型。

- 模型大小: 模型越大,需要的硬件资源越多,成本越高。

- 模型效率: 选择效率高的模型,可以提高推理速度。

- 模型适配: 将模型适配到本地硬件环境。

- 模型格式转换: 将模型转换为本地硬件支持的格式。

- 模型优化: 对模型进行优化,以提高推理速度。

4. 其他条件

- 技术团队: 需要具备深度学习、GPU、Linux等方面的技术知识和经验(个人或中小团队使用一般建议在windows上部署)。

- 运维能力: 需要具备模型部署、监控、维护等方面的运维能力。

- 成本: 本地部署大模型需要大量的硬件和软件成本。

- 安全性: 需要考虑模型安全、数据安全等问题。

- 并行要求: 需要考多人使用时,则需要考虑并行,并行又分为物理并行(即部署多个推理服务器)、线程并行(即在同一个服务器上运行多个线程同时进行推理,该方式由哲涛在UpHub AI中提供,可以充分利用硬件资源进行并行推理,但资源利用是按倍数增长,比如一个并行和2个并行所需资源是乘2)、模拟并行(即在一个推理线程中模拟多个任务同时处理,这是模拟并行,需要把模型支持的上下文切分成并行数,每个并行平分,该方式损失上下文长度,也是现在主流框架支持的方式,比如:llama.cpp、ollama等,即batch处理)等。具体采用什么并行方式,应该按实施部署的预算来。

总之

实施AI大模型本地化部署推理是一个综合性的工程,需要考虑硬件、软件、模型、技术团队、运维能力、并行、成本和安全性等多个方面。 在实际部署之前,需要进行充分的评估和规划,以确保项目的顺利进行和成功。

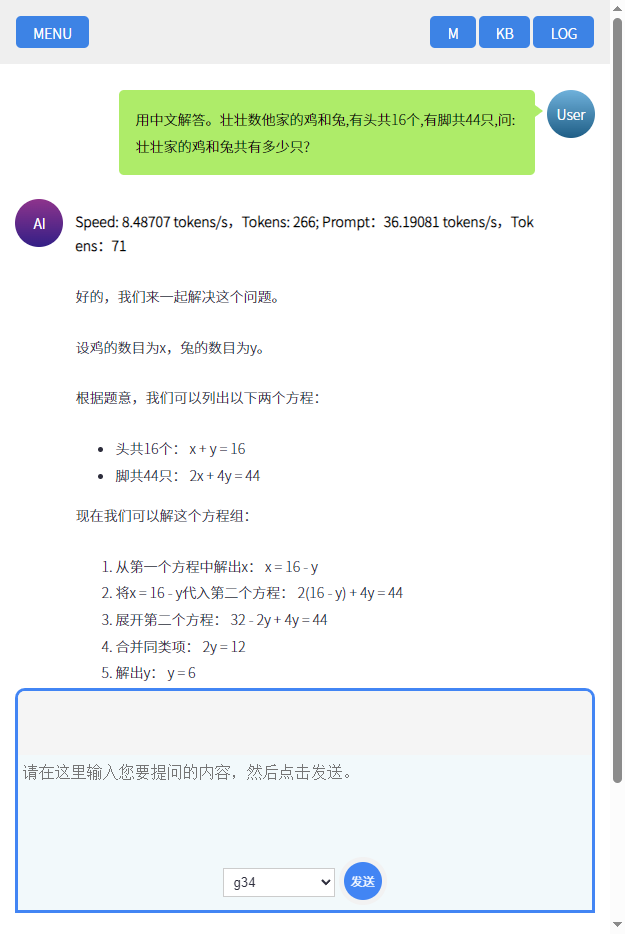

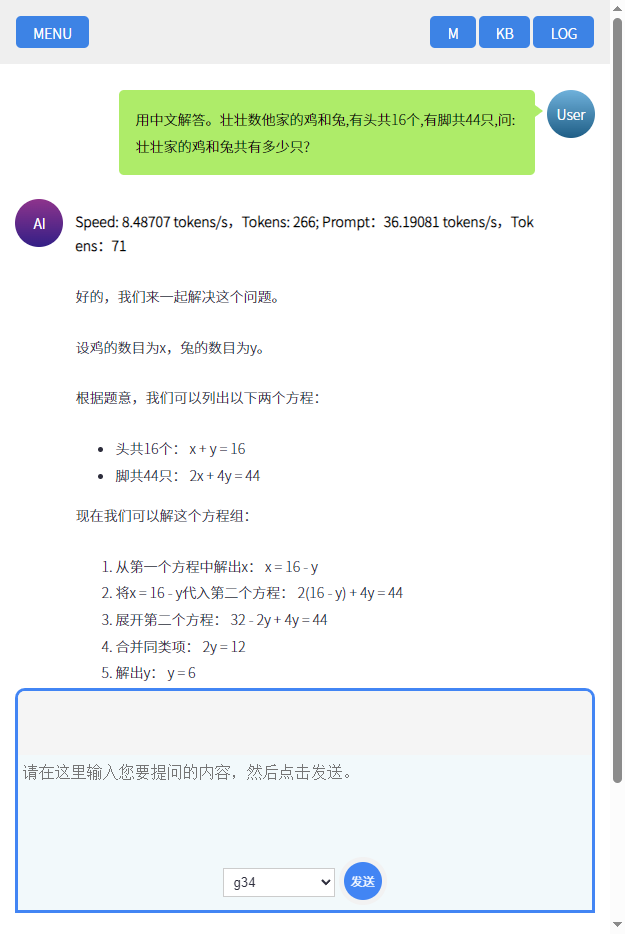

下图为在UpHub AI中运行Google的开源大模型Gemma3 多模态大模型进行推理举例:

UpHub AI Gemma3 4B大模型部署与推理举例

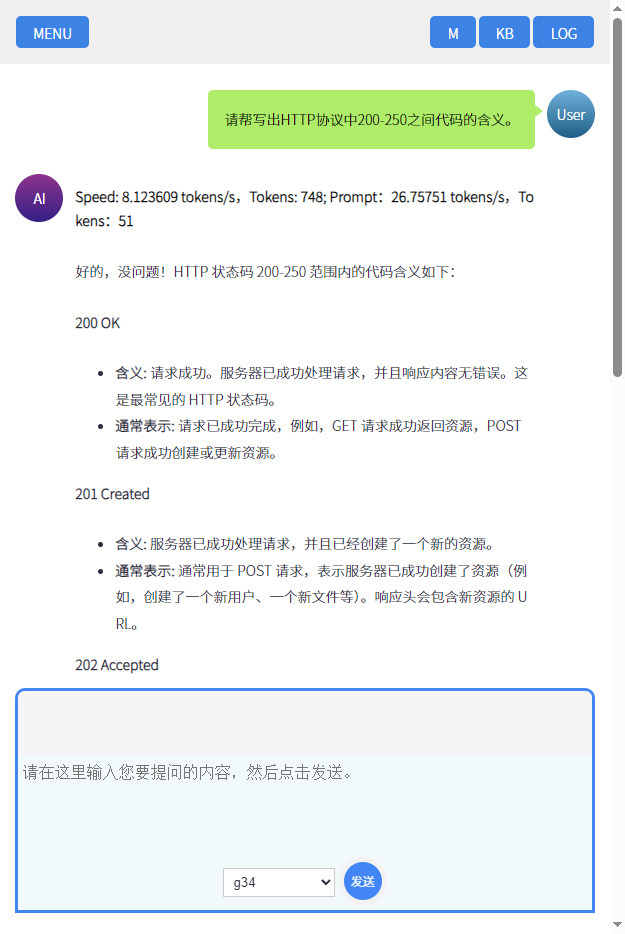

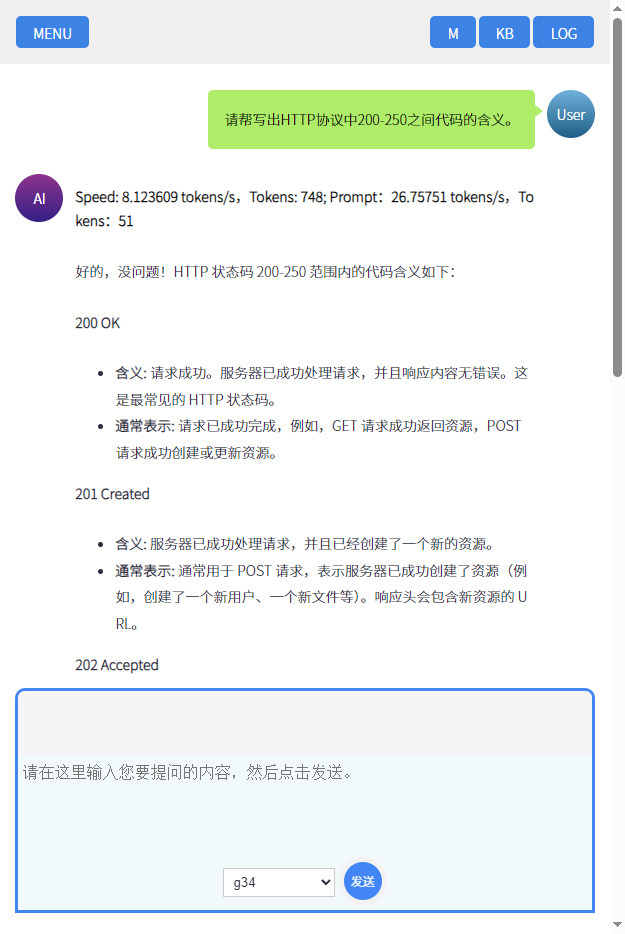

再比如,让大模型告诉我HTTP 200-250之间的状态表的含义:

UpHub AI 运行Google Gemma3 4B大模型,推理HTTP状态码