Deepseek-R1-0528开源大模型本地部署与运行

在人工智能技术飞速发展的浪潮中,大型语言模型(LLM)正以前所未有的速度改变着我们获取信息、创造内容和交互的方式。近期,由 DeepSeek 发布的 DeepSeek-R1-0528 开源大模型引起了广泛关注。该模型不仅在能力上有所提升,更以其兼容性和便捷性,为用户提供了在本地私有化部署和运行的强大可能性。本文将详细介绍 DeepSeek-R1-0528 的发布背景、核心优势,并重点指导如何利用 UpHub AI 这一工具实现其本地部署与运行。

DeepSeek 公司此前已经发布了 DeepSeek-V3 等一系列模型,积累了丰富的研发经验和用户反馈。在此基础上,DeepSeek 团队于 2025 年 05 月 28 日发布了 DeepSeek-R1-0528 版本。

这个版本的发布非常低调,主要通过 HuggingFace 平台向开发者和研究者社区开放。它并非一次简单的模型迭代,而是 “以 DeepSeek-V3 作为基座,提升了思维训练和推理能力” 的重要成果。这意味着 DeepSeek-R1-0528 在继承 V3 基础模型优势的同时,特别加强了在复杂逻辑、多步推理和抽象思维方面的表现。

一个引人瞩目的亮点是,该模型在 “数学测试 AIME 2024” 中取得了优异的成绩。AIME(美国高中数学竞赛)是一个对数学能力要求极高的测试,其优异表现充分证明了 DeepSeek-R1-0528 在逻辑推理和数学问题解决方面的强大实力,这对于需要精确推理和复杂计算的应用场景具有重要意义。

除了原生的 DeepSeek-R1-0528 大模型外,同时通过蒸馏DeepSeek-R1-0528的思维链后训练Qwen3-8B Base,得到了DeepSeek-R1-0528-Qwen3-8B。该版本及相关的gguf版已经可以在modelscope中下载和使用。

要让这些强大的开源模型在本地运行,离不开合适的工具支持。UpHub AI 正是一款专注于 AI 大模型私有化部署和推理的软件平台。它提供了一个基于 WEB 界面的用户交互方式,使得模型部署和使用变得简单直观。

UpHub AI 的核心优势在于:

llama.cpp 开发的推理后端,以其高效和轻量为特点。在 DeepSeek 发布 R1-0528 模型时,UpHub AI 已经在其最新版本(或特定版本)中内置了对 DeepSeek-R1-0528 的兼容性。

具体部署步骤如下:

选择在本地部署和运行 DeepSeek-R1-0528 模型主要有以下几个优势:

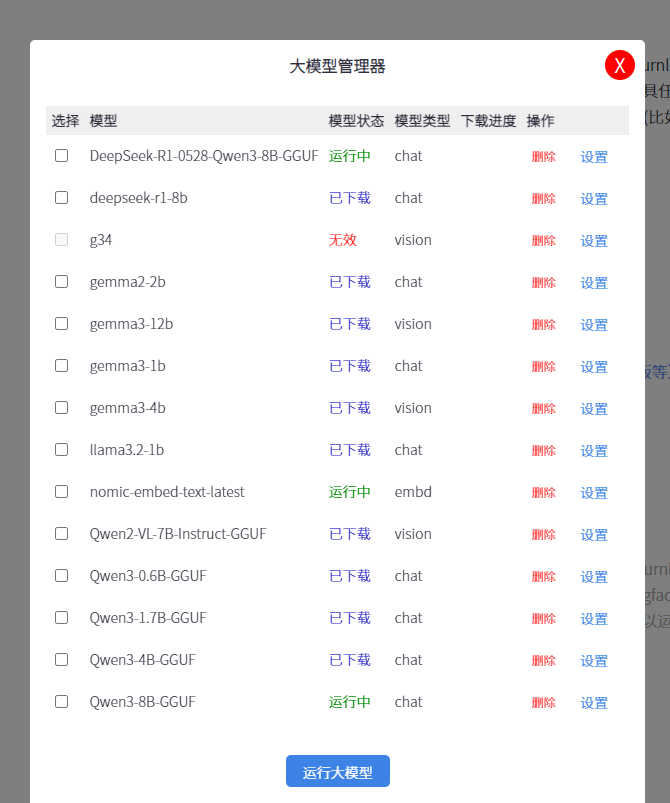

(1) 下载模型:只需要把GGUF模型的仓库网址(比如modelscope.cn中的相应网址),复制到模型管理器即可。

(2) 运行模型;

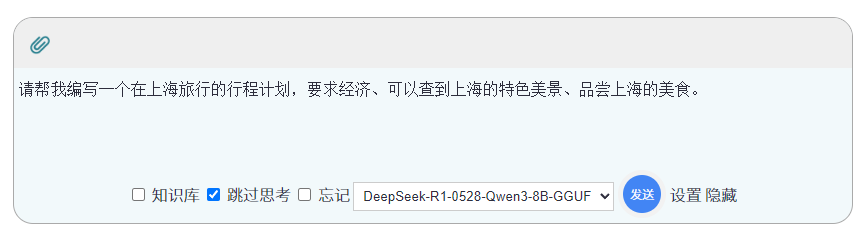

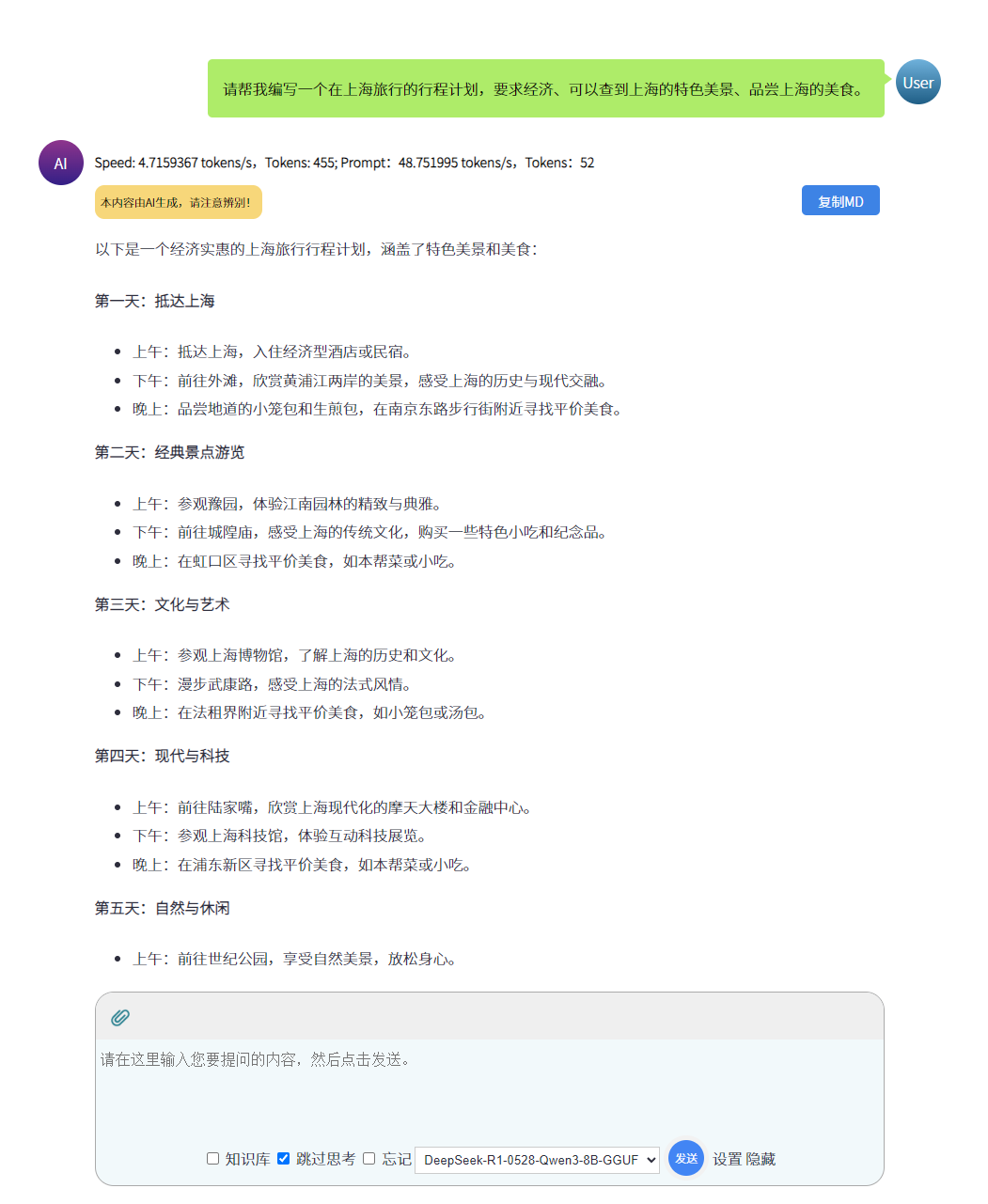

(3) 进行对话。