要在Windows上本地运行DeepSeek大模型,需要经过以下步骤。

Ollama 是一个开源的大型语言模型(LLM)推理程序,ollama可以让用户能PC电脑、服务器本地运行、管理和与大型语言模型并进行进行交互。 Ollama 主要通过命令行方式来使用各种预训练的语言模型进行推理,支持文本生成、翻译、代码编写、问答等多种自然语言处理任务。

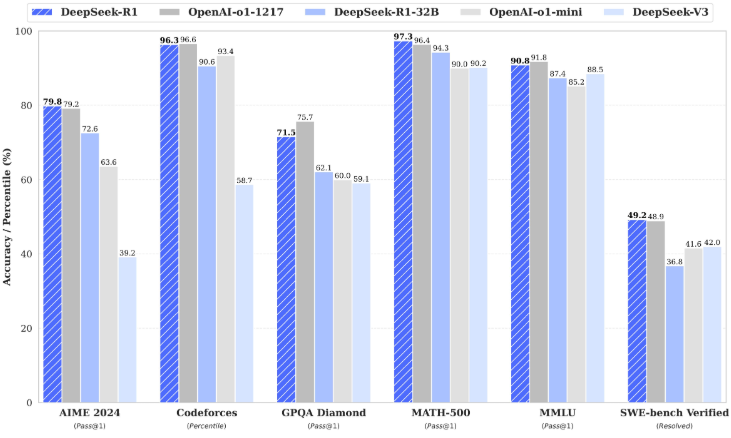

图片来源于DeekSeek官网

一、准备运行环境

DeepSeek不同版本的大模型运行所需配置不同,对于没有GPU专业计算卡的电脑通常只能运行7B-8B及以下参数的大模型。

大模型实际是一个Tokens的权重数据文件,这个文件通常几G到几百G不等,因此运行大模型时存放大模型的硬盘应该是高IO的高速硬盘,比如:M2接口的硬盘,一般的SSD或HDD则可能很难运行。

其次是内存的要求。通常使用int量化版的比fp32的要小很多,一般16GB-32GB的电脑就可以运行7B的大模型。

二、下载ollama

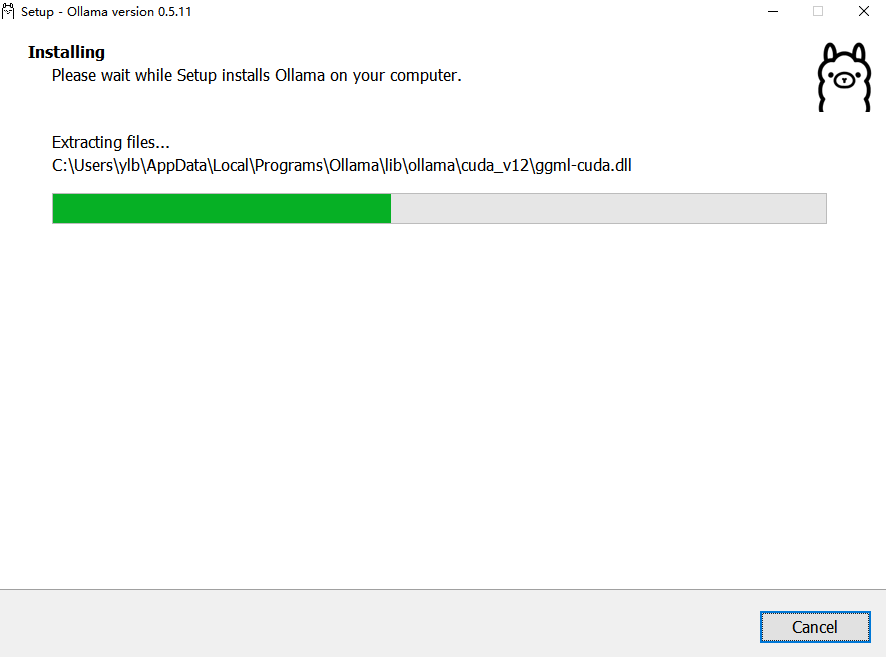

从官方网站下载:https://ollama.com/ (尽量从官网下载,以避免其它来源的安装包存在病毒)。下载后按安装程序安装即可。

ollama默认安装在C盘(默认安装位置:C:\Users\YOURNAME\AppData\Local\Programs\Ollama,模型下载位置为C:\Users\YOURNAME\.ollama。 ),并且在GUI安装中不可选择目录,如果要安装到指定目录,可以使用命令行安装。

OllamaSetup.exe /DIR=E:\Ollama

这样就可以安装到E:\Ollama目录了。安装其它目录这里换即可。

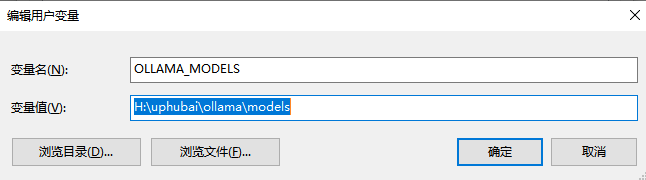

更换模型下载路径(默认下载到:C:\Users\YOURNAME\.ollama\models)。

添加环境变量:OLLAMA_MODELS,值为新的模型路径。设置后,要重新运行命令行和ollama服务(右下角羊驼图标,右键Exit)。

三、运行DeepSeek大模型

直接打开命令行(cmd),输入:ollama run deepseek-r1:7b 就可以运行7b的大模型了。

同样,输入 ollama run deepseek-r1:8b 可以运行8B版本,输入 ollama run deepseek-r1:1.5b可以运行1.5B版本。

ollama run deepseek-r1:14b 运行14B版本;

ollama run deepseek-r1:32b 运行32B版本。

等等...。

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b