个人使用UpHub AI在普通PC电脑上运行大模型实现知识问答解决方案

人工智能大模型正在改变我们的工作和生活方式。然而,使用这些强大的工具也带来了一些挑战,尤其是数据安全和隐私问题。将敏感信息上传到公共AI服务存在风险,而部署和维护大型AI模型需要大量的计算资源和专业知识,这让许多个人和小型组织望而却步。本文将介绍如何使用UpHub AI个人版,在普通PC电脑上运行大模型,实现知识问答解决方案,解决上述难题,并提供详细的部署和使用步骤。

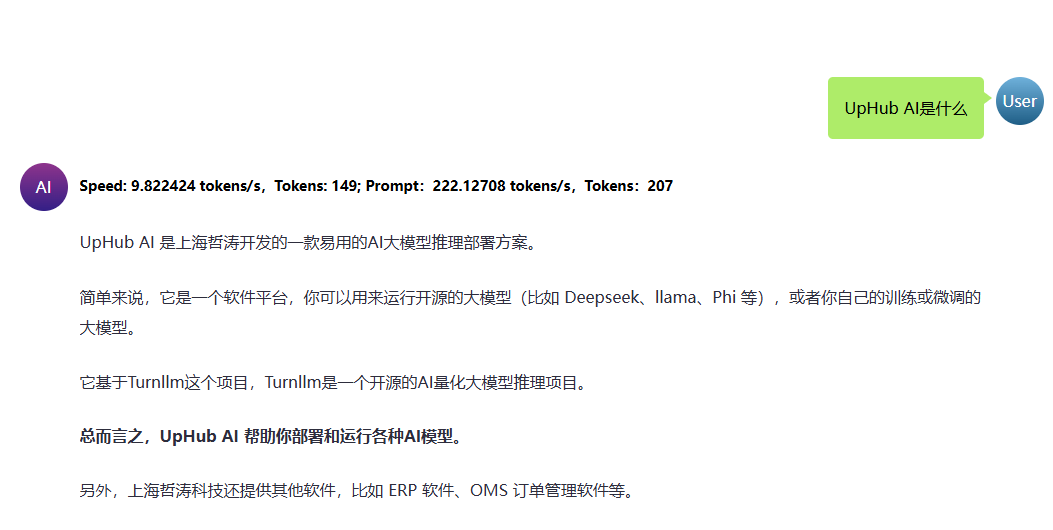

UpHub AI应运而生,旨在解决这些问题。它基于“生产者-消息者”架构,实现AI或企业业务应用流程的步骤(任务管理中心),为个人和小型组织提供了一个易于部署、安全可靠的AI解决方案。

UpHub AI个人版解决方案旨在帮助个人用户在普通PC电脑上构建一个能够进行知识问答的AI系统。

核心组件:

系统架构模块:

UpHub AI 个人版

turnllama.cpp (推理引擎)

gguf 量化大模型

RAG 知识库 (可选,个人版支持一个知识库的创建)

web用户界面

工作流程:

硬件要求:

软件准备:

安装 UpHub AI 个人版:

配置 RAG 知识库 (可选,个人版提供一个知识库,企业版可在web界面管理多个知识库):

启动 AI 推理服务:

界面操作:

知识库举例

优化提问技巧:

自定义推理配置(企业版可配置):

RAG 知识库优化:

监控与日志:

UpHub AI 个人版为个人用户提供了一个便捷、安全、高效的AI知识问答解决方案,让在普通PC上像安装一般软件一样就可以运行大模型。通过将AI推理、任务管理与RAG知识库解耦,降低硬件资源需求,并提供易于使用的界面,UpHub AI 降低了AI应用的门槛,让更多人能够享受到AI带来的便利。