企业使用UpHub AI在普通PC或消费级显卡中实现AI大模型推理与知识问答解决方案

人工智能大模型正以前所未有的速度改变着各行各业,但对于小微企业而言,将其应用于实际业务场景却面临着巨大的挑战。传统的大模型部署往往需要昂贵的专业硬件(如高性能GPU服务器)、专业的运维团队以及复杂的软件环境,这使得大部分小微企业望而却步。数据安全和隐私问题也进一步限制了企业使用公共AI服务的意愿。

UpHub AI企业精简版应运而生,致力于解决小微企业在AI落地过程中的痛点。它提供了一种创新的解决方案,利用“生产者-消息者”的架构模式,以及灵活的软件架构,采用llama.cpp开发的turnllm(turnllama.cpp)作为默认AIer(AI推理节点),让企业能够在普通的PC或消费级显卡上部署和运行AI大模型,并实现知识问答功能,同时保障数据安全和降低成本。

下载本地大模型部署推理软件UpHub AI,请点击这里。

一、问题分析:企业面临的AI落地挑战

在深入探讨UpHub AI的解决方案之前,我们首先需要明确小微企业在AI落地过程中遇到的主要挑战:

- 硬件成本高昂: 大模型推理需要大量的计算资源,通常需要高性能GPU服务器,成本极高。

- 专业团队缺乏: AI模型的部署、微调、维护需要专业的AI工程师和运维人员,而小微企业往往缺乏这类人才。

- 数据安全风险: 使用公共AI服务存在数据泄露的风险,对于企业内部数据安全至关重要。

- 软件环境复杂: AI模型的部署涉及大量的软件依赖关系,例如推理程序、API调用、RAG知识库等,配置和维护起来非常复杂。

- 集成难度大: 将AI模型与现有业务系统集成需要大量的开发工作,增加了实施难度和时间成本。

二、UpHub AI解决方案概述

UpHub AI解决方案的核心在于:降低AI大模型部署的门槛,让AI推理与业务系统解耦,实现高性能、高可用(企业高可用版提供支持),并支持在普通PC或消费级显卡上运行。 其主要优势体现在以下几个方面:

- 硬件兼容性: 基于llama.cpp,能够在CPU、内存、磁盘、显卡等资源有限的PC上运行。

- 架构解耦: 采用“生产者-消息者”模式,将AI推理程序与业务系统完全解耦,降低了集成难度和维护成本。

- 高性能、高可用: 利用Verip-MQ、Verip-KVCache、Verip-NetIO等技术,构建高可用的AI任务架构,保证推理服务的稳定性和可靠性。

- 弹性架构: 根据用户规模实现弹性架构,turnllama只是一个默认推理AIer,实现部署中企业可根据人员配置、硬件资源等选择其它推理程序,比如:vLLM、openai兼容的API、ollama API等,灵活部署,满足不同企业的需求。

- 易于部署与使用: 提供便捷的打包安装程序,一键安装软件,一键下载大模型,降低了部署难度,像安装普通软件一样就可以本地化部署和运行大模型。

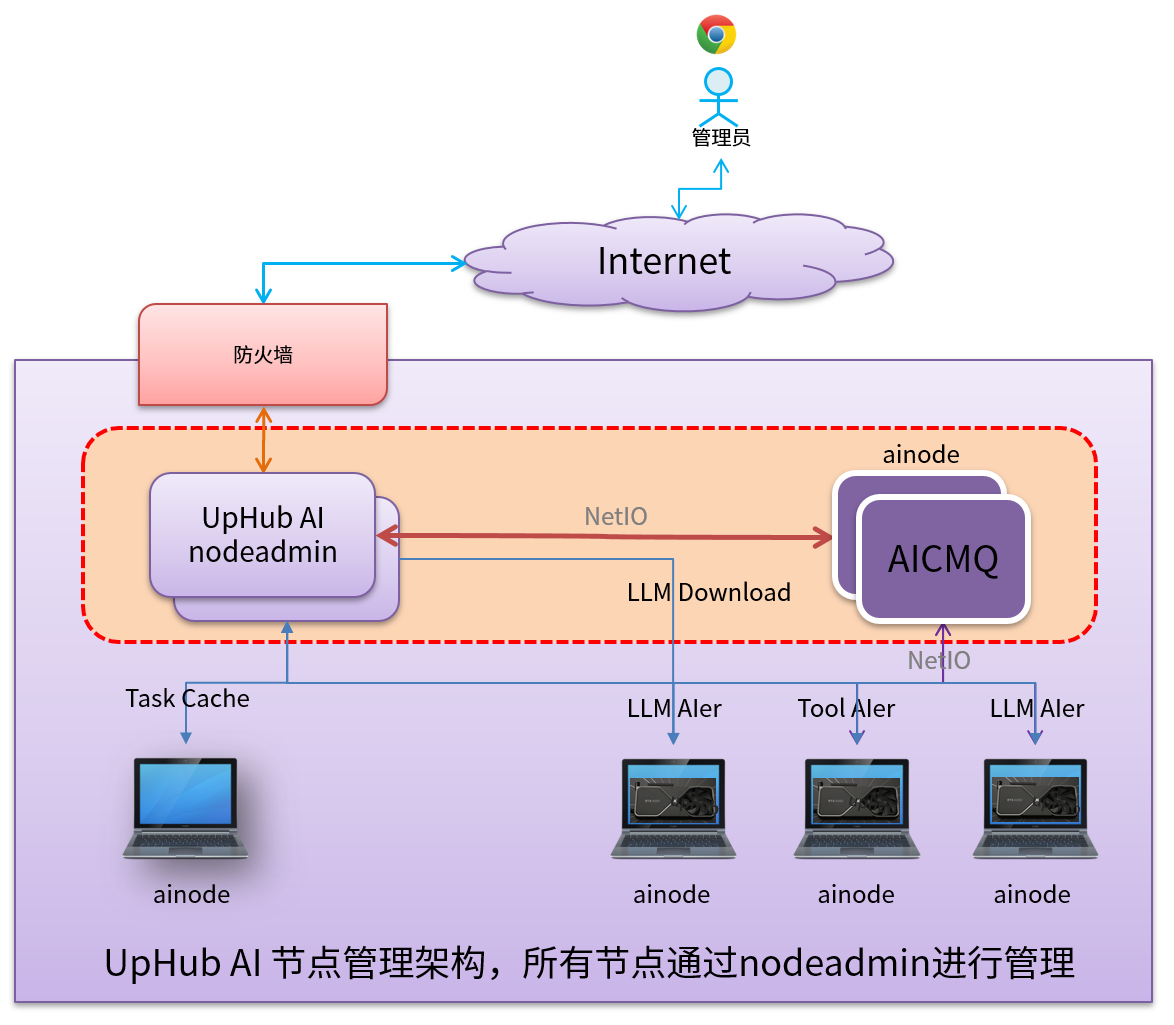

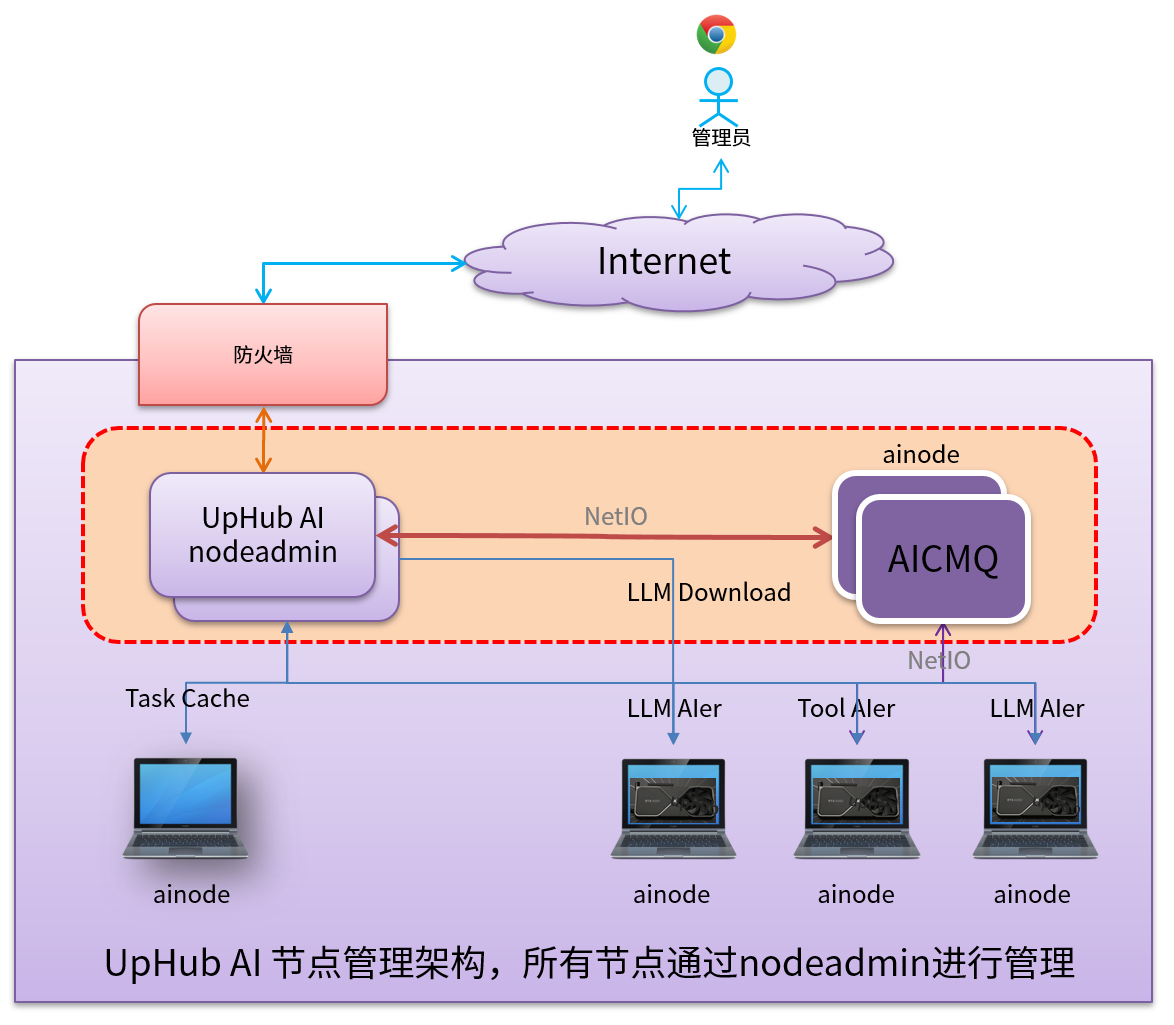

UpHub AI企业版架构

三、UpHub AI技术架构详解

UpHub AI的核心技术架构可以概括为以下几个关键组成部分:

-

默认llama.cpp集成: UpHub AI默认使用llama.cpp作为推理引擎。llama.cpp是一个开源的基于gguf格式的量化大模型的推理库项目,它针对CPU环境进行了优化,能够在消费级硬件上实现相对较高的推理速度。 gguf格式的量化模型进一步降低了内存占用和计算复杂度。

-

“生产者-消息者”架构: 这是UpHub AI最核心的架构设计。

- 生产者: 业务系统,负责产生AI推理任务,并将任务信息发送到消息队列。

- 消息队列: UpHub AI利用Verip-MQ作为消息队列,负责接收、存储和分发AI推理任务。

- 消费者: AI推理程序(AIer),从消息队列中拉取任务,进行AI推理,并将结果上传回业务系统。

这种架构的优势在于:

- 解耦: AI推理程序无需关心任务的来源和业务逻辑,专注于推理任务的执行。

- 可扩展性: AI推理节点可以根据需求进行无限扩展,只需要增加硬件资源即可。

- 高可用性: 消息队列保证了任务的可靠传递,即使AI推理节点出现故障,任务也不会丢失。

-

Verip-MQ、Verip-KVCache、Verip-NetIO: 这三者是UpHub AI构建高可用AI任务架构的关键组件。

- Verip-MQ: 高性能、高可靠的消息队列,负责任务的调度和分发。

- Verip-KVCache: 分布式缓存系统,用于缓存推理结果,提高响应速度。

- Verip-NetIO: 高性能网络I/O库和较量级传数据传输协议,优化数据传输效率。

-

RAG知识库模块: UpHub AI提供简易的RAG(Retrieval-Augmented Generation)知识库模块,允许用户将文档整理成知识库,实现自有知识库的推理和搜索。 这对于企业构建专属的问答系统至关重要。

-

灵活性: UpHub AI并非强制绑定llama.cpp,用户也可以选择使用Python自编实现pytorch和transformer(比如:vllm、openai的兼容API等)进行推理和反馈结果。 这种灵活性保证了AI推理任务的定制化和扩展性。

四、UpHub AI企业精简版快速部署指南

UpHub AI企业精简版针对小型团队提供了便捷的部署方案。

- 下载安装包: 从UpHub AI官方网站下载安装包。

- 一键安装: 运行安装包,按照提示完成软件安装。

- 一键下载模型: 安装完成后,软件会自动提供大模型下载选项,用户可以选择适合自己硬件配置的模型(注:模型也可以手动下载,投放到models目录中即可)。

- 配置密码: 分配用户,设置密码,保障系统安全性。

- 创建知识库: 将需要用于问答的文档导入到RAG知识库模块中。

- 开始使用: 通过界面进行AI推理和知识问答。

- API支持:UpHub AI提供与openai兼容的API,包括:对话等。

五、UpHub AI企业版部署考量

对于有更高可用性和性能要求的企业,UpHub AI提供了企业精简版和高可用企业版。 部署时需要考虑以下因素:

- 硬件选择: 根据用户规模和推理需求选择合适的硬件配置。 建议采用多节点部署,提高系统的可靠性。

- 并发要求:如果企业需要更多的并发和可扩展的推理节点,应该选择高可用企业版。

- 网络环境: 确保网络连接稳定,避免网络延迟影响推理性能。

- 安全策略: 制定完善的安全策略,保护数据安全和隐私。

- 运维团队: 建立专业的运维团队,负责系统的维护和升级。

六、案例分析:小微企业如何利用UpHub AI

- 电商客服: 利用UpHub AI构建智能客服系统,自动回答客户常见问题,提高客服效率。

- HR招聘: 利用UpHub AI筛选简历,提高招聘效率,降低招聘成本,避免数据泄露。

- 法律咨询: 利用UpHub AI进行法律文书分析,提供法律咨询服务。

- 教育培训: 利用UpHub AI构建智能辅导系统,提供个性化的学习体验。

七、最后

UpHub AI企业精简版为小微企业提供了一个切实可行的AI大模型落地解决方案,它降低了AI部署的门槛,保障了数据安全,并提供了高性能、高可用的推理服务。通过采用“生产者-消息者”架构和llama.cpp等技术,UpHub AI让AI推理不再是大型企业的专属,而是能够被更广泛的用户所应用。

未来,UpHub AI将持续优化技术架构,提升推理性能,扩展功能模块,并提供更完善的客户服务,助力小微企业拥抱AI时代,实现业务增长和创新。 我们期待着更多的小微企业能够利用UpHub AI的精简版力量,将AI技术应用于实际业务场景中,创造更大的价值。

附录: UpHub AI版本选择参考

| 版本 |

适用场景 |

主要特点 |

价格 |

| 个人免费版 |

个人学习、测试、小型项目 |

免费,单用户,强制密码,简易RAG库 |

免费 |

| 企业精简版 |

小型企业、初创公司 |

易于部署,性能稳定,基本功能 |

适中 |

| 高可用企业版 |

大型企业、对可用性要求高的应用场景 |

高性能、高可用、弹性架构、专业支持 |

较高 |